新一代大數據與人工智能基礎架構技術的演進與未來

隨著數據量的爆炸式增長和算法模型的持續深化,大數據與人工智能基礎架構技術正迎來新一輪的革新浪潮。這一演進不僅關乎計算效率的提升,更在于如何構建一個能夠支撐智能應用規模化、敏捷化發展的堅實基座。作為其中的核心,人工智能基礎軟件的開發正從輔助工具演變為驅動整個智能生態系統的關鍵引擎。

一、 基礎架構的融合與重構

傳統上,大數據平臺與人工智能訓練推理平臺往往各自為政,導致數據流轉效率低下、資源調度復雜。新一代技術架構的核心趨勢是 “一體化” 與 “云原生”。

- 存算分離與統一數據湖倉:通過將存儲與計算解耦,并構建融合數據湖與數據倉優勢的“湖倉一體”(Lakehouse)架構,實現了對海量多模態數據(如文本、圖像、視頻)的統一存儲、管理和高速訪問。這為AI模型提供了高質量、易獲取的“燃料”。

- 云原生與彈性調度:Kubernetes等容器編排技術已成為AI基礎架構的事實標準。它使得計算資源(尤其是GPU、NPU等異構算力)能夠像水和電一樣被彈性調度、動態伸縮,大幅提升了資源利用率和開發部署的敏捷性。無服務器(Serverless)計算模式的引入,進一步讓開發者聚焦于算法與業務邏輯。

二、 人工智能基礎軟件的崛起與深化

基礎軟件是連接底層硬件算力與上層AI應用的關鍵“中間件”,其發展正呈現三大特征:

- 框架的標準化與高性能化:以PyTorch、TensorFlow、JAX等為代表的深度學習框架,在易用性、靈活性上已趨成熟。當前競爭的焦點轉向 “性能” 與 “編譯優化” 。諸如PyTorch 2.0的TorchDynamo/TorchInductor、TensorFlow的XLA等編譯技術,能夠將動態圖高效編譯并優化到特定硬件后端,實現數倍的訓練與推理加速。

- 工具鏈的自動化與一體化:AI開發正從“手工作坊”走向“自動工廠”。MLOps(機器學習運維)理念催生出一系列覆蓋全生命周期的基礎軟件:

- 特征平臺:實現特征的統一計算、存儲和在線服務。

- 模型開發平臺:提供從自動化特征工程、模型自動調參(AutoML)、到大規模分布式訓練的一站式環境。

- 模型部署與服務平臺:實現模型的一鍵部署、A/B測試、灰度發布與在線監控,確保模型服務的穩定與高效。

- 面向大模型的專用棧:以Transformer為核心的千億、萬億參數大模型,對基礎軟件提出了極限挑戰。專為大模型設計的 “AI Infra Stack” 應運而生,其核心包括:

- 分布式訓練框架:如DeepSpeed、Megatron-LM,通過張量并行、流水線并行、數據并行等混合并行策略,將超大規模模型拆分到成千上萬個GPU上協同訓練。

- 高效推理引擎:如FasterTransformer、vLLM,通過算子融合、動態批處理、量化、稀疏化等技術,極大降低大模型的推理延遲與成本。

- 提示工程與編排工具:隨著大語言模型(LLM)的普及,LangChain、LlamaIndex等工具成為構建AI Agent應用的新一代基礎軟件,負責管理提示模板、連接外部工具與數據源。

三、 未來趨勢與挑戰

技術的發展將圍繞以下幾個方向展開:

- 軟硬件協同設計(Co-design):針對AI負載定制的芯片(如GPU、NPU、DPU)層出不窮,基礎軟件必須深度協同,通過編譯器、運行時庫將硬件算力“榨干”。開源開放的統一中間層(如ONNX、OpenXLA)將是關鍵。

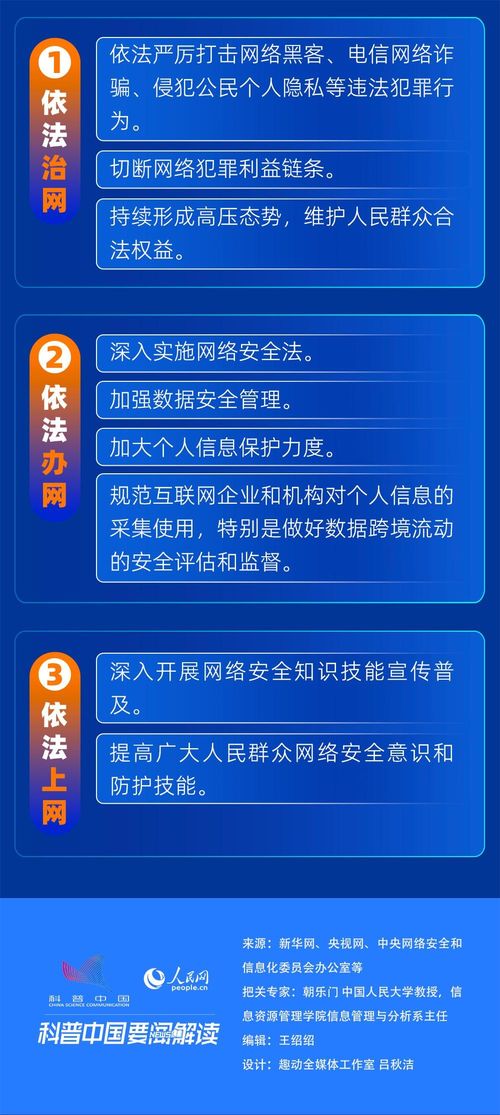

- 數據與AI治理的智能化:隨著法規(如GDPR、AI法案)的完善,數據隱私、模型公平性、可解釋性變得至關重要。基礎架構需內嵌智能化的數據血緣追蹤、模型審計和偏見檢測能力。

- 從“大數據+AI”到“AI for Infra”:人工智能技術將反向用于優化基礎架構自身,實現智能化的資源調度、故障預測、性能調優和成本控制,形成自優化的智能基礎設施。

- 開源與生態的競爭:技術壁壘正從單一框架轉向全棧能力與生態繁榮度。擁有從芯片、框架、平臺到應用的全棧開源生態體系,將成為贏得未來的關鍵。

###

新一代大數據與人工智能基礎架構及其軟件開發,正從支撐性角色轉變為價值創造的核心驅動力。它不再僅僅是“后臺”的技術堆棧,而是決定企業能否高效、合規、規模化地釋放數據智能潛能的關鍵戰略資產。未來的競爭,將是基礎設施智能化程度與開發者體驗的競爭。唯有構建起堅實、靈活且智能的基礎軟件層,方能在洶涌的AI浪潮中立于潮頭。

如若轉載,請注明出處:http://www.ykjw.net/product/44.html

更新時間:2025-12-30 12:48:54